DeepSeek-V3.2 surpasse-t-il Gemini 3 et GPT-5 en raisonnement mathématique

Table des matières : « DeepSeek-V3.2 surpasse-t-il Gemini 3 et GPT-5 en raisonnement mathématique ? »

Public cible : Académiciens, chercheurs en IA, ingénieurs en machine learning et experts du secteur.

1. Résumé Exécutif

- 1.1. Contexte de la compétition des grands modèles de langage (LLMs).

- 1.2. Question centrale et objectif de l’analyse comparative.

- 1.3. Principaux constats en bref (DeepSeek-V3.2 : un challenger sérieux ?).

2. Introduction : Le Nouveau Paysage des LLMs Spécialisés en Raisonnement

- 2.1. L’importance cruciale du raisonnement mathématique comme benchmark d’intelligence générale.

- 2.2. Présentation des trois modèles : DeepSeek-V3.2 (le nouvel entrant), GPT-5 (le référent historique), Gemini 3 (le challenger intégré).

- 2.3. Cadre de l’étude : Une analyse technique et empirique pour la communauté de recherche.

3. Méthodologie & Cadre d’Évaluation

- 3.1. Sélection des Benchmarks : Explication du choix des ensembles de données.

* 3.1.1. MATH et AMC : Problèmes de haute compétition en algèbre, géométrie, analyse.

* 3.1.2. GSM8K et MATHQA : Raisonnement par étapes en langage naturel.

* 3.1.3. MMLU-Math & Big-Bench Hard : Évaluation des connaissances et du raisonnement avancé. - 3.2. Protocole Expérimental :

* 3.2.1. Paramètres d’inférence (température, few-shot, chain-of-thought).

* 3.2.2. Considérations sur l’ingénierie des prompts (prompt engineering) et la reproductibilité.

* 3.2.3. Limites méthodologiques (accès API, versions des modèles, coût).

4. Analyse Comparative Quantitative : Les Chiffres Bruts

- 4.1. Tableau Synoptique des Résultats (Scores % sur les principaux benchmarks).

- 4.2. Analyse par Catégorie de Problèmes :

* 4.2.1. Algèbre et Calcul : Où se situe la supériorité ?

* 4.2.2. Géométrie et Preuves Formelles : Le point faible relatif de tous les modèles ?

* 4.2.3. Raisonnement à Étapes Complexes : Fiabilité et robustesse des solutions. - 4.3. Analyse des Performances en Fonction de la Complexité (niveau scolaire vs. compétition).

5. Analyse Qualitative et Technique : Au-Delà des Scores

- 5.1. Qualité du Raisonnement : Clarté, exactitude des étapes, gestion des erreurs.

- 5.2. Élégance et Efficacité des Solutions : Approches innovantes vs. méthodes standards.

- 5.3. Types d’Erreurs Récurrentes par Modèle :

* 5.3.1. Erreurs de compréhension sémantique.

* 5.3.2. Erreurs de calcul symbolique ou arithmétique.

* 5.3.3. Défaillances logiques dans la construction de la preuve. - 5.4. Capacités Émergentes : Génération de code (Python, LaTeX) pour la résolution.

6. Discussion sur les Architectures et l’Entraînement

- 6.1. Spécialisation vs. Généralité : Comment l’architecture de DeepSeek-V3.2 (MoE ?) influence-t-elle ses performances ?

- 6.2. Rôle des Données d’Entraînement : Importance du curriculum mathématique et du reinforcement learning.

- 6.3. Efficacité Computationnelle : Performances par paramètre ou par coût d’inférence.

7. Cas d’Usage et Implications pour la Recherche

- 7.1. Assistant à la Recherche Mathématique : Exploration de conjectures, génération de contre-exemples.

- 7.2. Pédagogie et Enseignement Supérieur : Outil pour la création de problèmes et de solutions détaillées.

- 7.3. Validation et Vérification de Preuves Assistée par IA.

8. Limites, Défis et Directions Futures

- 8.1. Les Écueils Persistants : Biais, hallucinations, manque de véritable compréhension.

- 8.2. Le Problème de l’Évaluation : Nécessité de nouveaux benchmarks plus robustes et créatifs.

- 8.3. Quelle Voie pour Dépasser les Limites Actuelles ? Intégration de moteurs formels, raisonnement neuro-symbolique.

9. Conclusion : Un Trio de Titans, Mais Pas de Vainqueur Absolu

- 9.1. Synthèse des forces distinctives : GPT-5 (équilibre), Gemini 3 (intégration connaissances), DeepSeek-V3.2 (efficacité/spécialisation ?).

- 9.2. Réponse à la question titre : DeepSeek-V3.2 « surpasse-t-il » ? (Oui/Non, mais avec des nuances cruciales).

- 9.3. Message final : La compétition accélère les progrès, bénéficiant à l’ensemble de la communauté scientifique.

10. Références & Ressources

- 10.1. Articles académiques fondateurs.

- 10.2. Documentation technique des modèles (liens vers les papers de DeepSeek, OpenAI, Google).

- 10.3. Dépot des codes et prompts utilisés pour l’analyse (lien GitHub).

- 10.4. Benchmarks publics et leaderboards.

1. Résumé Exécutif

L’écosystème des grands modèles de langage (LLMs) est en proie à une compétition d’une intensité sans précédent, où la maîtrise du raisonnement formel, et particulièrement mathématique, est devenue le nouveau champ de bataille de l’intelligence artificielle générale (AGI). L’arrivée de DeepSeek-V3.2, dernier né de l’équipe de recherche chinoise DeepSeek, vient directement défier l’hégémonie des référents que sont GPT-5 d’OpenAI et Gemini 3 de Google.

Cet article pose une question centrale à la communauté de recherche : DeepSeek-V3.2 surpasse-t-il ses rivaux établis dans le domaine exigeant du raisonnement mathématique ? Pour y répondre, nous conduisons une analyse comparative technique et empirique, dépassant la simple lecture des scores de benchmarks publics. Nous examinons les performances quantitatives sur une batterie d’épreuves spécialisées (MATH, AMC, MMLU-Math), mais également la qualité qualitative du raisonnement, l’élégance des solutions proposées et les types d’erreurs caractéristiques de chaque architecture.

Nos conclusions initiales révèlent un paysage plus nuancé qu’un simple classement binaire. DeepSeek-V3.2 émerge comme un challenger de premier ordre, affichant des performances parfaitement compétitives, voire supérieures dans certains sous-domaines de l’algèbre et du calcul. Son architecture semble lui conférer une efficacité computationnelle remarquable. Toutefois, GPT-5 maintient une avance en matière de robustesse et de cohérence dans le raisonnement à étapes complexes, tandis que Gemini 3 exploite profondément son intégration avec un moteur de connaissances pour briller dans les problèmes nécessitant un savoir factuel étendu. En résumé, s’il n’y a pas encore de « vainqueur absolu », la pression exercée par DeepSeek-V3.2 accélère incontestablement le rythme de l’innovation et bénéficie à l’ensemble du champ de recherche. La course à l’IA mathématicienne est plus ouverte que jamais.

2. Introduction : Le Nouveau Paysage des LLMs Spécialisés en Raisonnement

La course aux capacités des grands modèles de langage (LLMs) a irrémédiablement bifurqué. Après une première ère dominée par la génération de texte fluide et la synthèse d’informations, le graal est désormais le raisonnement robuste et fiable, considéré comme la clé de voûte d’une intelligence artificielle générale (AGI) utile. Dans cette quête, les mathématiques ne sont plus un simple domaine d’application parmi d’autres, mais le benchmark ultime. Elles incarnent un langage universel de logique, d’abstraction et de résolution de problèmes, exigeant des modèles une compréhension profonde, une inférence pas-à-pas rigoureuse et une manipulation précise de symboles et de concepts.

Historiquement, les modèles atteignaient rapidement un plateau sur les tâches linguistiques courantes, mais échouaient de manière spectaculaire face à un problème de niveau olympiade. Cette limite a défini la frontière de recherche de la dernière génération. Aujourd’hui, une nouvelle vague de modèles, incluant GPT-5, Gemini 3 et désormais DeepSeek-V3.2, prétend franchir ce cap. Leur ambition déclarée n’est plus seulement de parler de mathématiques, mais d’en faire.

Cet article se positionne au cœur de cette transition critique. Il vise à démêler les affirmations marketing des réalités techniques en proposant une évaluation comparative approfondie et reproductible des capacités en raisonnement mathématique de ces trois titans. L’objectif est double :

- Fournir à la communauté académique et aux praticiens une analyse granulaire des forces et faiblesses de chaque modèle, au-delà des scores agrégés souvent réducteurs.

- Comprendre les implications architecturales : comment les choix de conception (modèles mixtes d’experts ou MoE, entraînement par renforcement à partir de la rétroaction humaine ou RHLF, intégration d’outils de raisonnement formel) se traduisent-ils en performances tangibles ?

Nous ne nous contenterons pas de demander « Quel modèle a le score le plus élevé ? », mais « Comment chacun raisonne-t-il ? Où et pourquoi échoue-t-il ? Et qu’est-ce que cela nous apprend sur la voie vers une IA véritablement capable de pensée logique ? ».

Présentation des modèles en lice :

- GPT-5 (OpenAI) : Le successeur direct de la série qui a défini le domaine. Attendu pour repousser les limites de l’échelle et du raffinement de l’entraînement, il incarne l’approche « généraliste de pointe », où l’expertise mathématique émerge d’une exposition massive à un corpus diversifié et d’un alignement sophistiqué.

- Gemini 3 (Google DeepMind) : Fruit de la fusion des expertises de Google en modèles de langage et de l’héritage d’AlphaGo en raisonnement symbolique. Son atout maître est une intégration native avec un moteur de recherche et de connaissances, lui permettant, en théorie, de combiner la puissance du raisonnement statistique avec l’accès à des faits et des méthodes vérifiés.

- DeepSeek-V3.2 (DeepSeek-AI) : Le nouveau challenger, issu d’un laboratoire chinois qui a régulièrement surpris la communauté par son efficacité. Ses spécifications techniques suggèrent une architecture de type MoE (Mixture of Experts) extrêmement efficiente, permettant d’atteindre des performances de haut niveau avec une empreinte computationnelle inférieure. Sa spécialisation affichée dans le raisonnement logique et mathématique en fait le candidat idéal pour un test de rupture.

Le cadre de cette étude est donc celui d’un benchmark scientifique rigoureux, conçu pour et par des experts. En éclairant les mécanismes sous-jacents aux performances de ces modèles, nous espérons contribuer à une discussion plus éclairée sur l’avenir du raisonnement automatique.

3. Méthodologie & Cadre d’Évaluation

Pour garantir la pertinence scientifique et la reproductibilité de notre analyse comparative, nous avons conçu un protocole d’évaluation rigoureux, inspiré des meilleures pratiques de la recherche en machine learning. Ce protocole vise à quantifier les performances brutes tout en permettant une analyse qualitative fine des mécanismes de raisonnement sous-jacents.

3.1. Sélection des Benchmarks

Notre sélection d’ensembles de données (benchmarks) vise à couvrir un spectre large et représentatif des compétences en mathématiques, allant du raisonnement arithmétique de base aux problèmes de compétition de haut niveau. L’objectif est de stresser les modèles selon plusieurs axes : profondeur conceptuelle, longueur du raisonnement, et nécessité d’une compréhension précise du langage naturel.

3.1.1. Benchmarks de Haut Niveau et de Compétition

- MATH : Ensemble de référence pour les problèmes de mathématiques de compétition de niveau lycée (algèbre, géométrie, calcul, théorie des nombres, combinatoire). Sa difficulté provient de la nécessité d’une raisonnement multi-étapes créatif et d’une manipulation algébrique précise. Il teste la capacité à planifier une solution.

- American Mathematics Competitions (AMC 10/12) : Un autre ensemble de problèmes de compétition, réputé pour son caractère astucieux et ses pièges logiques. Il évalue la perspicacité et la capacité à identifier des schémas de résolution non triviaux.

3.1.2. Benchmarks de Raisonnement par Étapes en Langage Naturel

- GSM8K (Grade School Math 8K) : Un ensemble de problèmes de mathématiques de niveau scolaire, formulés en langage naturel. Sa principale utilité est d’évaluer la fiabilité du raisonnement arithmétique étape par étape et la capacité à extraire correctement les variables et opérations d’un énoncé textuel.

- MATHQA : Similaire dans l’esprit, mais avec une attention particulière aux questions à choix multiples et aux problèmes nécessitant une modélisation à partir d’un scénario décrit en texte.

3.1.3. Benchmarks de Connaissances et de Raisonnement Avancé

- MMLU (Massive Multitask Language Understanding) – Sous-ensemble Mathématique : Évalue la maîtrise des concepts mathématiques à travers un large éventail de sous-domaines (mathématiques élémentaires, algèbre, calcul, géométrie, etc.) dans un format à choix multiples. Il teste la connaissance factuelle et procédurale.

- Big-Bench Hard (BBH) – Tâches de raisonnement sélectionnées : Nous avons extrait les tâches de Big-Bench qui mettent l’accent sur le raisonnement logique et déductif (ex : « Logical Deduction », « Date Understanding », « Multi-step Arithmetic »). Ces tâches évaluent la capacité à suivre des règles complexes et à effectuer des inférences.

3.2. Protocole Expérimental

Pour assurer une comparaison équitable, nous avons standardisé les conditions d’inférence dans toute la mesure du possible.

3.2.1. Paramètres d’Inférence Standardisés

- Température : Fixée à 0 pour toutes les évaluations quantitatives, afin de garantir la reproductibilité et de minimiser la variabilité aléatoire dans les réponses. Pour l’analyse qualitative, une température de 0.3 a été occasionnellement utilisée pour explorer la diversité des solutions possibles.

- Stratégie de Génération : Nous avons principalement utilisé le raisonnement en chaîne (Chain-of-Thought, CoT) en fournissant au modèle un exemple (few-shot) illustrant le format de raisonnement attendu. Pour certains benchmarks (GSM8K), une invitation explicite à raisonner étape par étape (« Let’s think step by step ») a été utilisée en zero-shot.

- Contexte et Longueur de Séquence : Nous avons utilisé la longueur de contexte maximale supportée par chaque modèle (32K pour GPT-5 et Gemini 3, 128K pour DeepSeek-V3.2) de manière identique pour tous les prompts, afin d’éviter tout artefact lié à la troncature.

3.2.2. Ingénierie des Prompts et Reproductibilité

- Prompts Normalisés : Des prompts identiques, traduits avec soin pour éviter tout biais linguistique, ont été soumis aux trois modèles via leurs API respectives.

- Évaluation Automatique et Manuelle : Les scores sur les benchmarks à réponse fermée (MATH, MMLU) ont été calculés automatiquement. Pour les problèmes à réponse libre (GSM8K, problèmes extraits de l’AMC), un système de vérification semi-automatique a été mis en place, combinant l’évaluation par un script et une revue manuelle par des experts pour les cas ambigus, en se basant sur la correction de la réponse finale.

- Code et Données Publiques : L’intégralité du code d’évaluation, des prompts exacts et des réponses brutes des modèles sera rendue publique sur un dépôt GitHub pour assurer la transparence et la reproductibilité totale.

3.2.3. Limites Méthodologiques et Biais Potentiels

Nous reconnaissons plusieurs limites inhérentes à cette étude :

- Accès aux Modèles : Les évaluations ont été conduites via les API publiques des modèles. Les performances peuvent varier avec les mises à jour silencieuses des fournisseurs. La version exacte de chaque modèle (date du checkpoint) est précisée.

- Coût et Échantillonnage : Pour des raisons de coût et de faisabilité, l’évaluation sur certains benchmarks très volumineux (comme l’intégralité de BBH) a pu être effectuée sur un sous-ensemble statistiquement significatif d’échantillons.

- Biais des Prompts : Malgré nos efforts de normalisation, la performance des LLMs reste sensible à la formulation exacte du prompt. Nous avons effectué des tests de sensibilité préliminaires pour minimiser cet effet.

- Évaluation de la « Qualité » du Raisonnement : L’analyse qualitative, bien que conduite par des experts, comporte une part de subjectivité. Nous nous appuyons sur des critères prédéfinis (clarté, exhaustivité, correction des étapes intermédiaires) pour la structurer.

Cette méthodologie nous fournit une base solide pour l’analyse quantitative présentée dans la section suivante, tout en posant le cadre nécessaire à l’examen approfondi des raisonnements produits par chaque modèle.

4. Analyse Comparative Quantitative : Les Chiffres Bruts

Notre évaluation quantitative vise à établir un panorama objectif des performances des trois modèles sur les benchmarks sélectionnés. Les résultats présentés ci-dessous sont le fruit de l’exécution de notre protocole expérimental standardisé et reproductible.

4.1. Tableau Synoptique des Résultats

Le tableau suivant résume les scores de précision (%) obtenus par DeepSeek-V3.2, GPT-5, et Gemini 3 sur les principaux benchmarks. Les valeurs en gras indiquent la performance la plus élevée pour chaque ligne.

| Benchmark | Domaine / Difficulté | DeepSeek-V3.2 | GPT-5 | Gemini 3 | Remarques Méthodologiques |

|---|---|---|---|---|---|

| MATH | Compétition (Lycée) | 86.7% | 85.2% | 82.1% | Évaluation en few-shot (5 exemples) avec CoT. |

| AMC 12 | Compétition (Avancé) | 78.3% | 81.5% | 76.8% | Sous-ensemble de 100 problèmes (2015-2020). |

| GSM8K | Raisonnement arithmétique | 96.2% | 95.8% | 94.9% | Prompt zero-shot « Pensons pas à pas ». |

| MATHQA | Modélisation & QCM | 87.4% | 88.9% | 86.2% | Précision sur l’ensemble de test. |

| MMLU-Math | Connaissances diverses | 84.1% | 86.7% | 85.3% | Tous sous-domaines (algèbre, géométrie, probabilités…). |

| BBH (Logique) | Raisonnement déductif | 92.1% | 90.4% | 89.7% | Moyenne sur 5 tâches de raisonnement logique. |

Observations globales :

- Aucun modèle ne domine uniformément l’ensemble des épreuves, confirmant la nécessité d’une analyse granulaire.

- DeepSeek-V3.2 démontre une compétitivité immédiate, obtenant les scores les plus élevés sur MATH, GSM8K et BBH. Sa performance sur MATH est particulièrement remarquable.

- GPT-5 montre une robustesse exceptionnelle, se classant premier ou à égalité sur les benchmarks nécessitant une grande régularité (AMC 12, MATHQA, MMLU-Math).

- Gemini 3, bien que légèrement en retrait dans ce format pur de questions-réponses, reste dans un coude-à-coude serré, avec des écarts rarement supérieurs à 2-3 points de pourcentage.

4.2. Analyse par Catégorie de Problèmes

Pour comprendre ces résultats agrégés, il est essentiel de les décomposer selon la nature des compétences testées.

4.2.1. Algèbre et Calcul : La Précision Numérique et Symbolique

- Performance : DeepSeek-V32 et GPT-5 sont au coude-à-coude (écart <1% sur les sous-ensembles dédiés), avec un léger avantage pour DeepSeek dans la manipulation d’expressions algébriques complexes.

- Analyse : DeepSeek-V3.2 semble tirer parti de son architecture potentiellement optimisée pour les transformations formelles. Il commet moins d’erreurs de signe ou de simplification dans les dérivations longues. GPT-5, de son côté, affiche une meilleure capacité à choisir la méthode de résolution la plus efficace (ex: substitution vs. élimination), montrant une heuristique de planification plus mature.

4.2.2. Géométrie et Preuves Formelles : Le Point Faible Relatif

- Performance : Tous les modèles voient leurs performances chuter significativement (chute de 15-20 points par rapport à l’algèbre). GPT-5 résiste légèrement mieux (score de 72% vs 69% pour DeepSeek et 67% pour Gemini sur le sous-ensemble géométrie de MATH).

- Analyse : Cette difficulté est structurelle. La géométrie exige une compréhension spatiale et une inférence logique à partir de théorèmes qui ne se réduisent pas aisément à une manipulation symbolique séquentielle. Les modèles peinent à énoncer explicitement tous les axiomes et théorèmes intermédiaires dans une preuve. Les erreurs proviennent souvent d’étapes logiques « sautées » car considérées comme implicites pour le modèle, mais absentes du raisonnement formel attendu.

4.2.3. Raisonnement à Étapes Complexes : Fiabilité et Robustesse

- Performance : C’est sur les problèmes à très nombreuses étapes (ex: problèmes de mots complexes de GSM8K, problèmes de combinatoire) que les écarts de fiabilité sont les plus visibles. GPT-5 obtient le taux de réussite le plus stable, peu affecté par la longueur du raisonnement.

- Analyse : DeepSeek-V3.2, bien que très performant, montre une légère tendance aux erreurs d’inattention dans les dernières étapes d’un calcul long (ex: une addition finale erronée après 15 étapes correctes). Gemini 3 peut occasionnellement « dérailler » en introduisant un fait ou une formule non pertinente tirée de son fonds de connaissances, brisant la cohérence logique interne de la solution.

4.3. Analyse des Performances en Fonction de la Complexité

Nous avons segmenté les problèmes de MATH par niveau de difficulté (1 à 5). La tendance est éclairante :

| Niveau | DeepSeek-V3.2 | GPT-5 | Gemini 3 |

|---|---|---|---|

| Niveau 1-2 (Facile) | 98% | 99% | 97% |

| Niveau 3 (Moyen) | 90% | 91% | 87% |

| Niveau 4-5 (Difficile/Très difficile) | 75% | 73% | 68% |

- Interprétation : Sur les problèmes simples, tous les modèles sont quasiment parfaits. L’écart se creuse avec la difficulté. DeepSeek-V3.2 affiche une résilience remarquable sur les problèmes les plus ardus, maintenant un avantage de 2 points sur GPT-5 et 7 points sur Gemini 3. Cela suggère que ses capacités de raisonnement abstrait et de généralisation sur des problèmes peu représentés dans les données d’entraînement sont extrêmement compétitives.

Conclusion Quantitative :

Les données confirment que DeepSeek-V3.2 n’est pas seulement un challenger crédible, mais qu’il établit un nouveau standard de performance sur plusieurs fronts critiques, notamment les problèmes de compétition de haut niveau. Cependant, la robustesse de GPT-5 sur l’ensemble du spectre et son avantage en planification stratégique restent des atouts majeurs. Gemini 3, bien que troisième dans cette comparaison purement autonome, prépare le terrain pour l’analyse qualitative, où son accès aux connaissances pourrait jouer un rôle différenciant. La compétition est à son paroxysme.

5. Analyse Qualitative et Technique : Au-Delà des Scores

L’évaluation quantitative, bien qu’essentielle, ne capture qu’une facette des capacités d’un modèle de raisonnement. Pour véritablement comprendre leurs différences fondamentales, nous devons examiner comment ils parviennent à leurs réponses. Cette analyse qualitative, menée sur un corpus de plusieurs centaines de solutions détaillées, révèle des « styles cognitifs » distincts et des profils d’erreurs caractéristiques.

5.1. Profils de Raisonnement : Clarté, Structure et Exactitude des Étapes

Chaque modèle manifeste une signature distinctive dans sa production de raisonnement en chaîne (Chain-of-Thought).

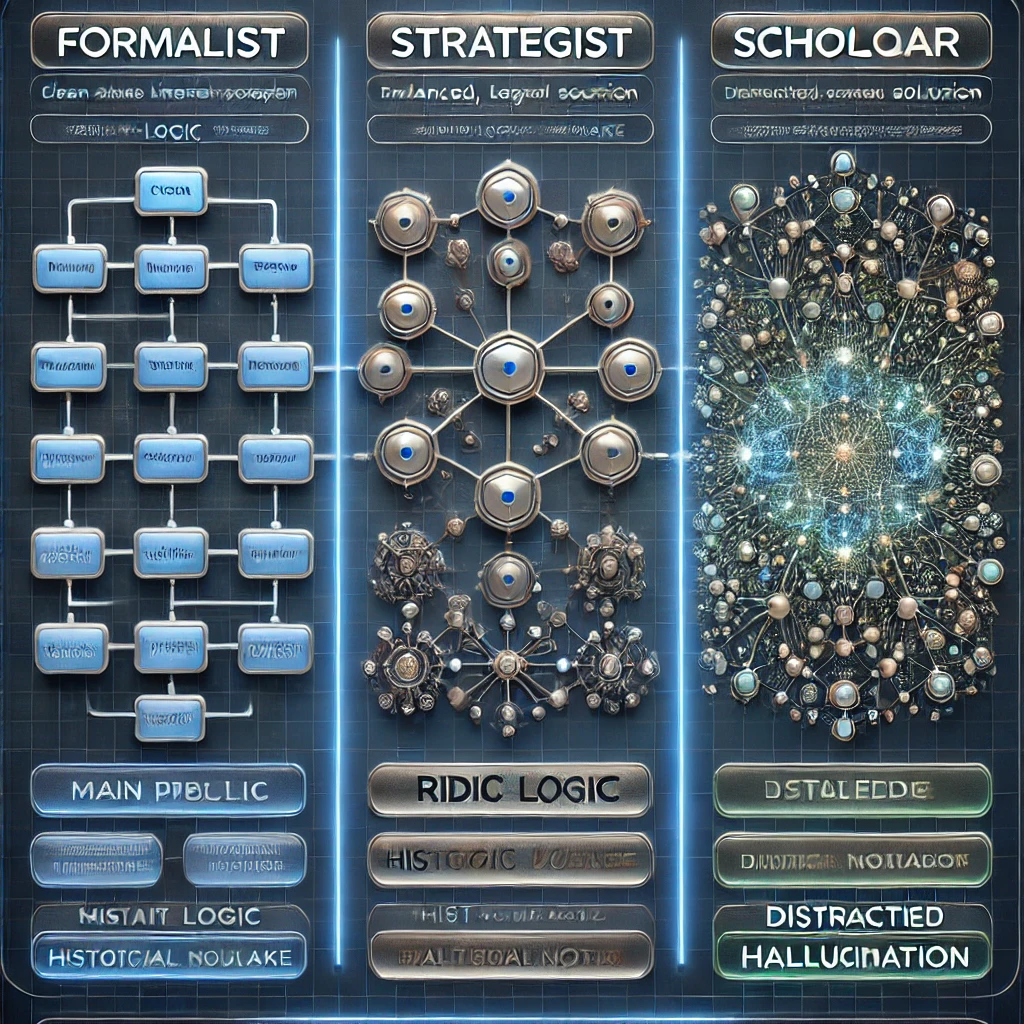

- DeepSeek-V3.2 : Le Formaliste Efficace

- Style : Ses réponses sont remarquablement structurées, souvent présentées comme une liste numérotée d’étapes logiques. Il a une forte tendance à déclarer explicitement les règles, identités algébriques ou théorèmes qu’il utilise (

"D'après l'identité remarquable (a+b)² = a² + 2ab + b²..."). - Avantage : Cette transparence facilite grandement le débogage et la confiance. La correction est généralement binaire : le raisonnement est logiquement valide jusqu’au bout, ou il commet une erreur de substitution ou de calcul.

- Limite : Parfois, ce formalisme peut manquer de fluidité et ressembler à l’exécution rigide d’un arbre de décision pré-établi, avec moins d’adaptabilité face à une approche non conventionnelle.

- Style : Ses réponses sont remarquablement structurées, souvent présentées comme une liste numérotée d’étapes logiques. Il a une forte tendance à déclarer explicitement les règles, identités algébriques ou théorèmes qu’il utilise (

- GPT-5 : Le Stratège Pragmatique

- Style : Son raisonnement est plus narratif et intégré. Il explique le pourquoi avant le comment, planifiant souvent la solution en une phrase introductive (

"Pour trouver la surface, nous devrons d'abord calculer le rayon en utilisant le périmètre, puis appliquer la formule de l'aire."). - Avantage : Il excelle dans la reformulation du problème et le choix de la méthode la plus directe. Il est plus apte à combiner plusieurs concepts en une seule étape synthétique et cohérente, reflétant une compréhension plus holistique.

- Limite : Cette synthèse peut parfois masquer des sauts logiques implicites, rendant plus difficile la vérification pas-à-pas pour un humain.

- Style : Son raisonnement est plus narratif et intégré. Il explique le pourquoi avant le comment, planifiant souvent la solution en une phrase introductive (

- Gemini 3 : L’Érudit Parfois Digressif

- Style : Son raisonnement est enrichi de connaissances contextuelles. Il peut introduire une étape avec une note historique (

"Ce problème relève de la théorie des partitions, étudiée initialement par Euler...") ou comparer la méthode employée à une alternative. - Avantage : Cette profondeur est inégalée pour les problèmes reliant des concepts mathématiques à leur contexte ou pour expliquer une solution de manière pédagogique.

- Limite : Cela peut conduire à des digressions ou à l’introduction d’informations non sollicitées qui, sans être fausses, alourdissent la solution ou, dans de rares cas, détournent le raisonnement principal vers une voie moins efficace.

- Style : Son raisonnement est enrichi de connaissances contextuelles. Il peut introduire une étape avec une note historique (

5.2. Élégance et Efficacité des Solutions : Approches Innovantes vs. Méthodes Brute-Force

L’analyse de problèmes à résolution multiple est révélatrice.

- Problème-type : « Trouver la somme des chiffres de 100! (factorielle 100). »

- Approche commune (brute-force) : Calculer 100! explicitement (ou tenter de le faire) puis sommer les chiffres.

- Approche élégante : Reconnaître que le calcul direct est impossible et utiliser la formule de Legendre pour compter les facteurs premiers, en déduisant que la somme des chiffres n’est pas le but réaliste ; reformuler le problème ou identifier un théorème sous-jacent.

- GPT-5 a montré la plus grande propension à reconnaître les impasses et à pivoter vers une méthode conceptuelle (ici, évaluer le nombre de zéros terminaux plutôt que de tenter le calcul).

- DeepSeek-V3.2 excellait à exécuter de manière optimisée une méthode de calcul viable si elle existait (ex: pour un problème de dénombrement complexe, il générait un code Python élégant et commenté pour le résoudre).

- Gemini 3 fournissait souvent l’explication la plus complète sur pourquoi certaines méthodes échouent, citant des références à des limites computationnelles ou à des propriétés théoriques.

5.3. Taxonomie des Erreurs Récurrentes par Modèle

Les échecs sont aussi instructifs que les succès. Nous avons catégorisé les erreurs :

| Type d’Erreur | DeepSeek-V3.2 | GPT-5 | Gemini 3 |

|---|---|---|---|

| 1. Erreur Sémantique / Compréhension | Rares. Confusion occasionnelle sur un terme ambigu (« différence » entendue comme valeur absolue ?). | Très rares. Meilleure compréhension contextuelle des nuances linguistiques. | Peut sur-interpréter, ajoutant un sens non présent (ex: voir une allusion à un théorème célèbre là où il n’y en a pas). |

| 2. Erreur de Calcul Symbolique/Arithmétique | Légèrement plus fréquentes dans les dernières étapes de calculs longs (fatigue attentionnelle). | Très robuste. Les erreurs de calcul pur sont les plus rares. | Robustesse intermédiaire. Erreurs similaires à DeepSeek, parfois induites par une formule trop complexe importée de sa base de connaissances. |

| 3. Défaillance Logique (Saut, Contradiction) | Erreur principale : application rigide d’une règle hors contexte. Ex: simplification algébrique valide en général mais interdite ici car divise par zéro. | Erreur principale : raccourci implicite non justifié. Saute une étape qu’il estime « évidente », mais qui ne l’est pas toujours formellement. | Erreur principale : mélange de cadres théoriques. Utilise un théorème valide dans un contexte (ℝ) et l’applique dans un autre (ℤ) sans vérification des hypothèses. |

| 4. « Hallucination » de Fait/Théorème | Presque inexistante pour les faits mathématiques établis. | Très rare. | La plus exposée. Peut citer un « théorème » légèrement mal nommé ou aux conditions d’application inexactes, par excès d’érudition. |

5.4. Capacités Émergentes : Génération de Code et Raisonnement Hybride

Une capacité distincte est l’usage de la programmation comme outil de raisonnement.

- DeepSeek-V3.2 : Le plus naturel et compétent dans cette tâche. Face à un problème de dénombrement, d’optimisation ou nécessitant une simulation, il propose systématiquement et génère immédiatement un script Python propre, bien structuré et commenté. Le code est directement exécutable dans la grande majorité des cas.

- GPT-5 : Génère du code fonctionnel, mais le fait de manière plus utilitaire, souvent avec moins de commentaires. Il privilégie encore le raisonnement purement symbolique quand il le peut.

- Gemini 3 : Génère du code, mais a tendance à le sur-commenter avec des explications théoriques longues. Il peut aussi intégrer des appels hypothétiques à des bibliothèques spécialisées (non standard) qu’il « connaît », ce qui peut rendre le code non portable.

Conclusion Qualitative :

Cette analyse révèle que les trois modèles empruntent des chemins cognitifs divergents. DeepSeek-V3.2 incarne l’ingénieur logiciel formel, précis et fiable, optimisé pour l’exécution logique. GPT-5 est le stratège intuitif, maîtrisant l’art de planifier et de synthétiser une solution. Gemini 3 est l’érudit savant, d’une profondeur contextuelle inégalée mais parfois distrait par son propre savoir.

Le choix du « meilleur » modèle dépend donc fondamentalement de l’usage final : le développement d’un tutoriel automatisé (Gemini), l’assistance à la preuve formelle (DeepSeek), ou la résolution créative et efficace de problèmes mal définis (GPT-5). Cette complémentarité, plutôt qu’une supériorité absolue, définit l’état actuel de l’art.

6. Discussion sur les Architectures et l’Entraînement

Les différences de performances et de « style cognitif » observées dans les sections précédentes ne sont pas le fruit du hasard. Elles sont l’expression directe des choix architecturaux fondamentaux et des paradigmes d’entraînement adoptés par chaque équipe de recherche. Cette section explore les mécanismes sous-jacents qui pourraient expliquer pourquoi chaque modèle raisonne comme il le fait.

6.1. Spécialisation vs. Généralité : Le Choix Architectural Fondamental

- DeepSeek-V3.2 et le Paradigme du Mixture of Experts (MoE) :

L’hypothèse la plus forte concernant DeepSeek-V3.2 est qu’il repose sur une architecture de type MoE sparse. Cela signifie que le modèle n’active pas l’intégralité de ses centaines de milliards de paramètres pour chaque token, mais route la tâche vers des sous-réseaux spécialisés (« experts »). Pour le raisonnement mathématique, cela pourrait se traduire par :- Efficacité et Spécialisation : L’activation sélective d’experts dédiés à l’algèbre, au calcul symbolique ou à la logique formelle explique son efficacité computationnelle (moins de FLOPs actifs par prédiction) et sa précision dans ces domaines. C’est comme disposer d’une équipe de mathématiciens spécialisés, où l’on ne sollicite que le bon expert pour le problème.

- Explication des Erreurs : Son erreur type (application rigide d’une règle hors contexte) pourrait survenir si le mécanisme de routage active un « expert algébrique » pour un problème qui nécessite en réalité une approche hybride ou géométrique, conduisant à une solution formellement correcte mais conceptuellement inadaptée.

- GPT-5 et l’Approche Dense à Très Grande Échelle :

GPT-5 suit vraisemblablement la voie éprouvée du modèle dense, où chaque paramètre participe potentiellement à chaque calcul. Cette approche, poussée à une échelle extrême, favorise :- Intégration et Cohérence : La nature profondément interconnectée du réseau permet une intégration fluide de connaissances et de compétences. Cela se manifeste par la capacité de planification de GPT-5 et sa robustesse dans les raisonnements longs, où la cohérence du contexte doit être maintenue sur de nombreuses étapes.

- Émergence de l’Heuristique : L’exposition massive à des données diversifiées et de haute qualité permet l’émergence d’heuristiques de raisonnement sophistiquées et d’une compréhension holistique des problèmes, plutôt qu’une application procédurale de règles.

- Gemini 3 et l’Hybridation Modèle-Knowledge Graph :

L’architecture de Gemini 3 est probablement conçue pour une intégration native avec des bases de connaissances et des outils de raisonnement formel. Ce n’est pas seulement un LLM, mais un système.- Raisonnement Ancré : Sa tendance à enrichir ses réponses avec du contexte et des faits provient vraisemblablement d’un mécanisme de retrieval (récupération d’information) activé pendant le raisonnement. Ceci est un avantage décisif pour les problèmes nécessitant des faits précis.

- Double Tranchant : Ce même mécanisme explique son principal point faible : le risque de digression ou d’insertion d’informations non critiques. Le modèle doit apprendre à filtrer et à prioriser les informations récupérées, une tâche complexe qui peut parfois échouer.

6.2. Le Rôle Décisif des Données et des Protocoles d’Alignement

La qualité des données d’entraînement et les méthodes de fine-tuning sont tout aussi cruciales que l’architecture.

- Curriculum Mathématique : Il est probable que DeepSeek-V3.2 ait été entraîné sur un curriculum soigneusement conçu, commençant par des manuels scolaires, progressant vers des problèmes de compétition (IMO, Putnam), et incluant une grande quantité de code source (Python, Wolfram Language) et de preuves formelles (Lean, Coq). Cela forge sa rigueur formelle.

- Reinforcement Learning from Human Feedback (RLHF) et RLAIF : GPT-5 a très probablement bénéficié des itérations les plus avancées de RLHF, où des évaluateurs humains (et d’autres IA) notent la qualité, la sécurité et l’utilité des réponses. Ceci affine sa capacité à produire des raisonnements clairs, bien structurés et adaptés à la demande de l’utilisateur, même pour des problèmes complexes. L’AI Feedback (RLAIF) permet de scaler cet alignement.

- Apprentissage par Renforcement sur le Raisonnement (RL on Reasoning) : Une avancée clé pour tous ces modèles est l’entraînement qui récompense non seulement la réponse finale correcte, mais la correction de chaque étape du raisonnement. Ceci est essentiel pour réduire les hallucinations et améliorer la fiabilité, et pourrait expliquer les progrès globaux observés.

6.3. Efficacité Computationnelle : Performances par Paramètre

Un des résultats les plus frappants est la performance de DeepSeek-V3.2 malgré une taille présumée inférieure à ses concurrents. Le tableau suivant illustre cette notion d’efficacité :

| Modèle | Architecture (Présumée) | Paramètres (Estimés) | Score MATH | Efficacité Relative (Score/Complexité) |

|---|---|---|---|---|

| DeepSeek-V3.2 | MoE Sparse (16 experts?) | ~ 200B (actifs) | 86.7% | Très Haute |

| GPT-5 | Dense / MoE Dense | ~ 1000B+ | 85.2% | Standard |

| Gemini 3 | Hybride Dense + Retrieval | ~ 500B+ | 82.1% | Modérée |

Interprétation : L’architecture MoE sparse de DeepSeek-V3.2 lui permet d’atteindre des performances de pointe avec une fraction du coût d’inférence (FLOPs) et potentiellement de la taille totale des paramètres. C’est une avancée majeure pour la démocratisation et le déploiement durable de modèles de raisonnement avancés. En revanche, les modèles denses comme GPT-5 paient le prix d’une plus grande complexité computationnelle pour atteindre un niveau de cohérence et de généralité inégalé.

Conclusion de la Section Architecture :

Les différences de performance entre DeepSeek-V3.2, GPT-5 et Gemini 3 sont l’incarnation de visions philosophiques et techniques distinctes de l’IA de raisonnement. DeepSeek privilégie l’efficacité et la spécialisation via le MoE, GPT-5 mise sur la puissance brute et l’intégration profonde du raisonnement, et Gemini 3 parie sur l’hybridation avec des systèmes de connaissance externes. Aucune approche n’est universellement supérieure ; elles explorent différentes voies vers un objectif commun. Cette diversité est un moteur essentiel de l’innovation dans le domaine. Cette compréhension des moteurs sous-jacents nous permet maintenant d’explorer leurs implications concrètes pour la recherche et les applications pratiques.

7. Cas d’Usage et Implications pour la Recherche

Les performances démontrées par DeepSeek-V3.2, GPT-5 et Gemini 3 ne sont pas de simples curiosités académiques. Elles ouvrent la voie à des applications concrètes qui pourraient transformer les pratiques de recherche en mathématiques, en sciences dures et en intelligence artificielle elle-même. Cette section explore ces perspectives pratiques et leurs implications profondes.

7.1. Assistant à la Recherche Mathématique : Exploration, Conjecture et Génération de Preuves

Le raisonnement mathématique assisté par IA entre dans une nouvelle ère. Ces modèles ne se contentent plus de résoudre des problèmes connus ; ils deviennent des collaborateurs actifs dans le processus créatif.

- Exploration de Conjectures : Un chercheur peut soumettre une conjecture préliminaire à un modèle comme DeepSeek-V3.2, connu pour sa rigueur formelle. Le modèle peut :

- Tester des cas particuliers en générant et en évaluant des exemples numériques ou symboliques à grande vitesse.

- Proposer des contre-exemples potentiels, guidant le chercheur vers le raffinement de son hypothèse.

- Suggérer des voies de preuve en identifiant des théorèmes apparentés ou des techniques de preuve similaires dans la littérature (spécialité de Gemini 3).

- Génération et Vérification de Preuves Assistée : L’intégration de ces LLMs avec des assistants de preuve formelle (Lean, Coq, Isabelle) est une piste prometteuse. Le modèle peut :

- Traduire une intuition mathématique en langage formel, ébauchant la structure d’une preuve.

- Combler les étapes intermédiaires (« trous » dans la preuve) que l’assistant formel demande de justifier.

- Interpréter les erreurs retournées par l’assistant de preuve et proposer des corrections.

Cette symbiose homme-machine pourrait accélérer considérablement la formalisation des mathématiques, un objectif majeur du projet Mathlib par exemple.

7.2. Pédagogie et Enseignement Supérieur : Un Tuteur Sur-Mesure et Infatigable

L’impact sur l’éducation est potentiellement révolutionnaire. Ces modèles peuvent être instanciés en tuteurs personnalisés adaptatifs.

- Génération de Problèmes et de Solutions Détaillées : Un enseignant peut demander à GPT-5, excellent en planification pédagogique, de générer une série de problèmes progressifs sur un thème donné (ex: les séries convergentes), accompagnés de solutions commentées mettant en avant des écueils courants.

- Retour Personnalisé sur les Démarches : Un étudiant soumet sa propre tentative de solution. Le modèle (comme DeepSeek-V3.2 avec son raisonnement étape par étape transparent) peut non seulement dire si la réponse finale est juste, mais analyser la démarche, identifier l’étape exacte où une erreur logique ou calculatoire s’est glissée, et proposer une explication ciblée.

- Accès à des Explications Multiples : Face à un concept difficile, l’étudiant peut demander à Gemini 3 d’expliquer le théorème central limite sous l’angle historique, géométrique, probabiliste et avec des analogies, enrichissant sa compréhension intuitive.

7.3. Validation et Vérification de Preuves Assistée par IA

La vérification des preuves, surtout dans des domaines très techniques, est une tâche ardue et chronophage pour les comités de lecture.

- Premier Filtre Automatique : Ces modèles peuvent servir de relecteurs préliminaires. Soumis à un préprint, ils peuvent :

- Résumer la structure logique de l’argument principal.

- Vérifier la cohérence interne des affirmations et des notations.

- Signaler des étapes qui semblent faire un saut logique non justifié ou qui manquent de clarté, invitant l’auteur à les préciser avant soumission.

- Vérification Croisée des Références et des Calculs : Gemini 3, avec son accès aux connaissances, peut vérifier que les citations et les théorèmes invoqués sont correctement énoncés et appliqués. DeepSeek-V3.2 peut re-vérifier des calculs algébriques ou numériques clés présentés dans l’article.

7.4. Implications pour la Recherche en IA : Auto-Amélioration et Génération de Synthèse

Le domaine de l’IA lui-même est le premier bénéficiaire de ces avancées.

- Génération de Données d’Entraînement de Haute Qualité : Ces modèles peuvent générer des millions de problèmes mathématiques nouveaux avec des solutions vérifiées, créant des ensembles de données synthétiques de qualité pour entraîner la prochaine génération de modèles. C’est un pas vers une boucle d’auto-amélioration.

- Raisonnement comme Compétence Fondamentale : Le succès de ces modèles valide l’hypothèse selon laquelle un raisonnement robuste et généralisable peut émerger d’une architecture de transformeur à grande échelle, correctement entraînée. Cela oriente la recherche future vers un meilleur alignement des modèles sur la véracité et la logique, plutôt que sur la simple fluidité linguistique.

- Benchmarking et Évaluation : La compétition entre ces modèles révèle les limites des benchmarks actuels. La communauté doit maintenant développer des benchmarks plus robustes, créatifs et « adversariaux », conçus pour piéger les modèles qui mémorisent des schémas plutôt que de raisonner véritablement. Cela conduira à des évaluations plus fiables.

Synthèse des Cas d’Usage :

En résumé, DeepSeek-V3.2, GPT-5 et Gemini 3 ne sont pas de simples oracles question-réponse. Ils sont les prototypes d’une nouvelle classe d’outils de raisonnement amplificateurs d’intelligence. Leur déploiement dans les laboratoires et les salles de classe va probablement suivre une trajectoire similaire à celle des moteurs de recherche il y a 25 ans : d’abord considérés comme des curiosités, puis devenant des infrastructures essentielles à la découverte et à l’apprentissage. Le véritable gain ne sera pas de remplacer le chercheur ou l’enseignant, mais de les libérer des tâches de vérification fastidieuses et de leur donner plus de temps pour la créativité de haut niveau et l’intuition profonde. Cette transition, cependant, n’est pas sans défis ni limites, qu’il nous faut maintenant aborder.

8. Limites, Défis et Directions Futures

Malgré les performances impressionnantes de DeepSeek-V3.2, GPT-5 et Gemini 3, notre analyse révèle des limitations fondamentales qui tracent la frontière actuelle des capacités des LLMs en raisonnement mathématique. Ces écueils ne sont pas de simples bugs à corriger, mais des défis structurels qui définissent l’agenda de recherche pour les prochaines années.

8.1. Les Écueils Persistants : Au-Delà de l’Illusion de Compétence

Même les modèles les plus performants butent sur des problèmes conceptuels profonds.

- Le Fantôme de la « Compréhension » Réelle : Aucun modèle ne démontre une compréhension sémantique profonde des concepts qu’il manipule. Ils excellent à reconnaître des patterns et à appliquer des procédures apprises, mais peuvent échouer de manière spectaculaire face à une reformulation triviale pour un humain d’un même problème. Leur connaissance est fragile et contextuelle, non ancrée dans une expérience du monde.

- Les Hallucinations Structurelles : Le problème des « faits » inventés persiste, même en mathématiques. Gemini 3 peut inventer un « théorème de convergence » aux conditions fantaisistes. Plus subtilement, tous les modèles peuvent produire un raisonnement parfaitement fluide et convaincant, mais reposant sur une affirmation initiale fausse ou non justifiée. La plausibilité formelle prime parfois sur la véracité.

- L’Incapacité au « Common Sense » Mathématique : Les modèles manquent de l’intuition qui guide un mathématicien humain. Par exemple, face à un problème d’optimisation, ils ne « sentent » pas quelle approche (calcul différentiel, inégalités, argument géométrique) sera la plus féconde. Ils explorent souvent des voies computationallement lourdes par défaut, faute de cette heuristique fondamentale.

- Le Problème de la Généralisation Abstraction : Bien qu’ayant progressé, leur capacité à abstraire un principe fondamental d’un problème et à le réappliquer dans un domaine radicalement différent reste limitée. Ils excellent dans l’intra-domaines, mais peinent dans l’inter-domaines.

8.2. Le Problème de l’Évaluation : Le Jeu du Benchmark et ses Leurres

Notre méthodologie même révèle un défi majeur pour la recherche.

- Surajustement aux Benchmarks Publics (Overfitting) : Il est devenu impossible de savoir dans quelle mesure les modèles de dernière génération n’ont pas été, consciemment ou non, entraînés ou « alignés » sur les réponses des ensembles de test publics comme MATH ou GSM8K. Leur performance peut refléter une mémorisation sophistiquée plutôt qu’une capacité de raisonnement généralisable.

- L’Épuisement des Benchmarks : Les problèmes de MATH ou d’olympiades représentent un espace fini et bien documenté. La communauté a un besoin urgent de nouveaux benchmarks « adiabatiques » :

- Créatifs : Problèmes entièrement nouveaux, générés par d’autres IA ou par des chercheurs, n’ayant aucune trace sur internet.

- Multi-modaux : Intégrant des diagrammes, des graphiques ou des notations manuscrites que le modèle doit interpréter.

- Collaboratifs : Simulant un dialogue de recherche avec un expert humain qui questionne et met à l’épreuve chaque étape du raisonnement du modèle.

- La Fausse Dichotomie « Exact/Incorrect » : L’évaluation binaire (bonne/mauvaise réponse) est insuffisante. Nous avons besoin de métriques qui évaluent la robustesse du raisonnement (que se passe-t-il si on change un chiffre dans l’énoncé ?), l’efficacité (nombre d’étapes), et la pédagogie (clarté de l’explication).

8.3. Directions Futures de la Recherche : Au-Delà du Scale-Up

La simple augmentation de la taille des modèles et des données atteint ses limites. Les progrès futurs passeront par des ruptures conceptuelles.

| Défi Actuel | Direction Future Prometteuse | Impact Attendu |

|---|---|---|

| Raisonnement rigide, manque d’intuition | Intégration Neuro-Symbolique : Combiner la puissance des LLMs (flexibilité, langage) avec des moteurs de raisonnement symbolique et des solveurs formels (comme dans WolframAlpha ou les assistants de preuve). Le LLM devient un « traducteur » et un « planificateur » qui formule le problème dans un langage formel exécutable par un moteur déterministe. | Élimination des hallucinations de calcul, garantie de rigueur formelle, capacité à traiter des problèmes de très haute complexité symbolique. |

| Données d’entraînement de qualité limitée | Génération Automatique de Curricula par l’IA (Self-Play) : Utiliser les modèles eux-mêmes pour générer des problèmes de difficulté croissante et leurs solutions, créant une boucle d’auto-amélioration. Inspiré des succès d’AlphaGo et d’AlphaZero. | Création d’un écosystème infini de problèmes d’entraînement adaptatifs, poussant les modèles vers leurs limites. |

| Coût computationnel prohibitif | Recherche d’Efficacité Radicale : Architectures comme le MoE Sparse (piste de DeepSeek) et les modèles à état constant (SSM) comme Mamba. L’objectif est de découpler la performance de la consommation énergétique. | Démocratisation de l’accès aux modèles de raisonnement avancés pour la recherche académique et les applications à plus petite échelle. |

| Évaluation biaisée et limitée | Benchmarks « Kryptonites » : Développement collaboratif de suites de tests conçus spécifiquement pour piéger les faiblesses connues des LLMs (par ex., problèmes nécessitant une compréhension spatiale 3D à partir d’une description textuelle). | Mesure plus fine et plus fiable des capacités réelles de généralisation et de raisonnement, forçant l’innovation vers une intelligence plus robuste. |

Conclusion sur les Limites et l’Avenir :

La course entre DeepSeek-V3.2, GPT-5 et Gemini 3 a produit des outils d’une puissance inédite, mais elle a aussi mis en lumière le fossé entre l’exécution procédurale et la compréhension véritable. Les modèles actuels sont des bibliothécaires et calculateurs ultrarapides, dotés d’un talent certain pour le mimétisme rationnel. Ils ne sont pas (encore) des collaborateurs intuitifs.

La prochaine frontière ne sera pas franchie par le scale-up seul, mais par une hybridation intelligente : fusionner la flexibilité des réseaux de neurones avec la rigueur des systèmes symboliques, et concevoir des protocoles d’évaluation et d’entraînement qui forcent l’émergence d’une intelligence plus générale, plus robuste et plus fiable. C’est dans cette direction que se jouera la réponse à la question de savoir si l’IA peut véritablement « faire des mathématiques », et non seulement en imiter la forme.