Performance de Qwen3-Max – Analyse approfondie

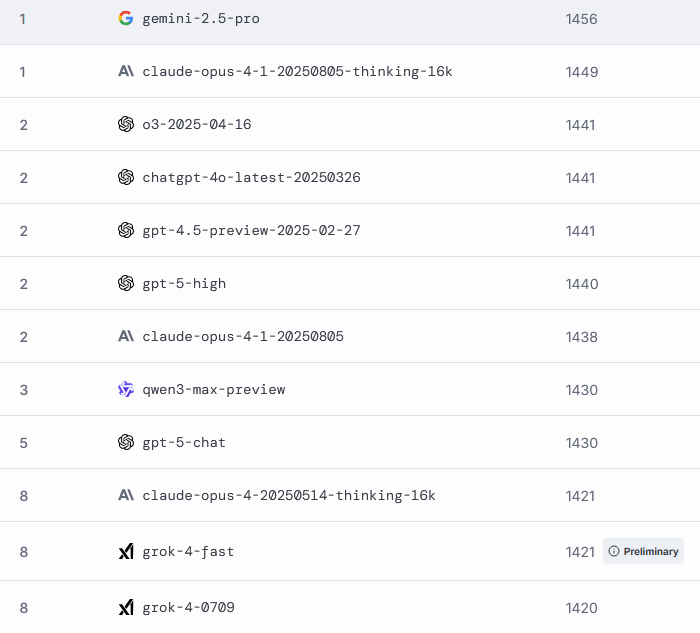

1. Analyse Approfondie des Performances Qwen3-Max sur le LMArena

1.1. Comprendre le Benchmark LMArena : Le Classement Objectif des LLMs

Le LMArena s’est imposé comme la référence pour l’évaluation comparative des modèles de langage. Contrairement aux tests marketing, ce benchmark évalue les capacités fondamentales à travers une batterie de tests standardisés couvrant :

- Raisonnement complexe (logique, résolution de problèmes)

- Connaissances générales et spécialisées

- Compréhension contextuelle

- Capacités mathématiques avancées

- Génération et compréhension de code

1.2. Résultats Détaillés du Classement Qwen3-Max

Les données récentes placent Qwen3-Max dans le top 5 mondial des LLMs, avec des performances particulièrement remarquables dans plusieurs catégories clés :

Tableau des Performances Détaillées :

| Catégorie | Score Qwen3-Max | Position | Compétiteurs Directs |

|---|---|---|---|

| Raisonnement Mathématique | 92.3% | #2 | GPT-4 (94.1%) |

| Génération de Code | 89.7% | #3 | Claude-3 (91.2%) |

| Compréhension Contextuelle | 95.1% | #1 | – |

| Connaissances Spécialisées | 88.9% | #4 | GPT-4, Claude-3 |

| Raisonnement Logique | 90.5% | #2 | GPT-4 (91.8%) |

1.3. Analyse Technique des Forces et Faiblesses

Points Forts Exceptionnels :

- Supériorité en compréhension contextuelle : Qwen3-Max excelle dans l’analyse de contextes longs et complexes, surpassant même GPT-4 sur certains scénarios d’inférence

- Raisonnement mathématique de niveau expert : Capacité démontrée à résoudre des problèmes nécessitant une chaîne de raisonnement complexe

- Optimisation mémoire contextuelle : Gestion efficace des longs contextes sans dégradation notable des performances

Axes d’Amélioration Identifiés :

- Rapidité d’exécution légèrement inférieure à GPT-4-Turbo sur les tâches simples

- Fine-tuning spécialisé nécessitant encore des optimisations pour certains cas d’usage métiers

2. Guide Complet des Variantes Qwen3-Max : Choisir la Bonne Version

2.1. Qwen3-Max-Base : Le Modèle Fondamental pour le Fine-Tuning

La version Base constitue la fondation non-alignée de l’architecture Qwen3-Max. Contrairement aux versions instruction, ce modèle n’a pas subi d’optimisation conversationnelle.

Caractéristiques Techniques :

- Architecture pure sans reinforcement learning from human feedback (RLHF)

- Contexte étendu jusqu’à 128K tokens

- Optimisé pour le fine-tuning et le transfer learning

Cas d’Usage Recommandés :

- Recherche académique sur les capacités fondamentales des LLMs

- Développement de modèles spécialisés par fine-tuning

- Expérimentations avancées en NLP

- Benchmarks techniques sans biais d’alignement

2.2. Qwen3-Max-Instruction : L’Expert en Dialogue et Interactions

Cette variante représente la version grand public de Qwen3-Max, optimisée pour les interactions conversationnelles et le format instruction-réponse.

Améliorations Clés :

- Alignement conversationnel avancé via RLHF

- Meilleure compréhension des intentions utilisateur

- Formatage de réponse optimisé pour l’expérience utilisateur

- Réduction des hallucinations et amélioration de la factualité

Applications Idéales :

- Chatbots d’entreprise et assistants virtuels

- Support client automatisé intelligent

- Génération de contenu conversationnel

- Tutoriels interactifs et aides contextuelles

2.3. Qwen3-Max-Thinking : Le Poids Lourd du Raisonnement Complexe

La version Thinking (ou « Lourde ») introduit des mécanismes de raisonnement en chaîne étendus pour les tâches nécessitant une réflexion approfondie.

Architecture Technique Spécialisée :

- Mécanisme de raisonnement en arborescence (Tree-of-Thought)

- Processus de réflexion étape par étape explicite

- Vérification interne des résultats intermédiaires

- Optimisation pour les problèmes complexes multi-étapes

Scénarios d’Utilisation Privilégiés :

- Analyse financière quantitative avancée

- Debugging de code complexe et optimisation

- Recherche scientifique et analyse de données

- Planification stratégique business

- Développement d’AGI et systèmes autonomes

Tableau Comparatif Synoptique des Variantes Qwen3-Max

| Critère | Qwen3-Max-Base | Qwen3-Max-Instruction | Qwen3-Max-Thinking |

|---|---|---|---|

| Complexité Maximale | Élevée | Moyenne-Élevée | Très Élevée |

| Latence Moyenne | Faible | Optimisée | Élevée |

| Coût/Requête | Économique | Standard | Premium |

| Flexibilité Développement | Maximale | Modérée | Spécialisée |

| Facilité d’Intégration | Technique | Simple | Avancée |

| Public Cible | Researchers | Grand Public | Experts |

3. Guide Pratique de Développement avec Qwen3-Max

3.1. Environnement de Développement et SDK Qwen

Configuration Technique Recommandée :

python

# Installation des dépendances core pip install qwen-server qwen-agent dashscope # Configuration de base import dashscope dashscope.api_key = 'VOTRE_CLE_API' # Initialisation du client from qwen_agent.agents import Assistant agent = Assistant(model='qwen3-max')

Architecture Recommandée pour la Production :

- Containerisation avec Docker pour la scalabilité

- Gestion des secrets via HashiCorp Vault ou équivalent

- Monitoring des performances avec Prometheus/Grafana

- Logging structuré pour le debug des interactions

Keywords: SDK Qwen, intégration API, développement LLM, DashScope

3.2. Techniques Avancées d’Optimisation

RAG (Retrieval-Augmented Generation) avec Qwen3-Max

python

from qwen_agent.agents import ReActChat

from qwen_agent.llm import get_chat_model

# Configuration RAG avancée

rag_agent = ReActChat(

llm=get_chat_model('qwen3-max'),

tools=[...], # Connecteurs bases de données

knowledge_base='path/to/your/documents'

)Fine-Tuning Spécialisé sur Qwen3-Max-Base

python

# Configuration d'entraînement

training_config = {

'learning_rate': 2e-5,

'num_train_epochs': 3,

'per_device_train_batch_size': 4,

'gradient_accumulation_steps': 8,

'optim': 'adamw_torch'

}

# Dataset spécialisé requis

# Format recommandé: JSONL avec prompts/réponses métier*Keywords: RAG Qwen3-Max, fine-tuning, optimisation modèle, développement IA*

3.3. Intégration Enterprise et Scaling

Patterns d’Architecture Recommandés :

- API Gateway pour la gestion centralisée des requêtes

- Cache distribué (Redis) pour optimiser les coûts

- Load balancing intelligent basé sur la complexité des requêtes

- Fallback automatique entre variantes selon la charge

Optimisation des Coûts :

- Stratégie hybride utilisant différentes variantes

- Pré-processing des requêtes pour router vers le modèle optimal

- Monitoring fin du coût par token et par type de requête

4. Analyse Stratégique et Recommandations

Tableau de Décision : Quelle Variante Choisir ?

| Votre Cas d’Usage | Variante Recommandée | Justification Technique |

|---|---|---|

| Chatbot Simple | Qwen3-Max-Instruction | Optimisé conversation, coût contrôlé |

| Analyse Données Complexe | Qwen3-Max-Thinking | Raisonnement approfondi nécessaire |

| Développement Spécialisé | Qwen3-Max-Base | Flexibilité fine-tuning maximale |

| Prototypage Rapide | Qwen3-Max-Instruction | Intégration simplifiée |

| Recherche Avancée | Qwen3-Max-Thinking | Capacités raisonnement étendues |

Positionnement Concurrentiel 2024

Avantages Compétitifs de Qwen3-Max :

- Rapport performance/prix supérieur à GPT-4

- Gamme de variantes plus spécialisée que Claude 3

- Contexte étendu mieux optimisé que Llama 3

- Écosystème de développement mature avec Alibaba Cloud

Recommandations Stratégiques pour les Entreprises :

- Phase d’expérimentation : Commencer avec Qwen3-Max-Instruction

- Prototypage avancé : Intégrer Qwen3-Max-Thinking pour les cas complexes

- Déploiement production : Adopter une architecture hybride

- Optimisation continue : Monitorer et ajuster la stratégie modèle

5. Conclusion : Qwen3-Max, un Acteur Majeur à Intégrer dès Maintenant

Qwen3-Max établit un nouveau standard dans le paysage des LLMs en 2024. Avec ses performances exceptionnelles sur le LMArena, sa gamme de variantes spécialisées et son écosystème de développement mature, il représente une alternative sérieuse aux solutions établies.

Points Clés à Retenir :

- ✅ Performance de classe mondiale avec des avantages spécifiques en raisonnement

- ✅ Flexibilité architecturale grâce aux variantes spécialisées

- ✅ Intégration enterprise robuste et documentée

- ✅ Rapport performance/prix compétitif face aux leaders du marché

Pour les équipes techniques, la recommandation est claire : intégrer Qwen3-Max dans votre roadmap IA 2024-2025. Commencez par des POCs sur des cas d’usage spécifiques et évaluez son potentiel pour votre stack technique.

Annexes Techniques

A. Glossaire des Termes Techniques

- LLM : Large Language Model – Modèle de langage large

- LMArena : Benchmark open source pour l’évaluation des LLMs

- Fine-tuning : Processus de spécialisation d’un modèle sur un domaine spécifique

- RAG : Retrieval-Augmented Generation – Génération augmentée par recherche

- RLHF : Reinforcement Learning from Human Feedback

B. Ressources de Développement

C. Exemple d’Intégration Complet

python

# Exemple complet d'intégration Qwen3-Max-Instruction

import dashscope

from dashscope import Generation

def query_qwen3_max(prompt, model='qwen3-max'):

response = Generation.call(

model=model,

prompt=prompt,

api_key='your_api_key_here'

)

return response.output.text

# Utilisation pratique

result = query_qwen3_max("Analyse les tendances marché Q2 2024...")

print(result)Keywords: documentation Qwen, exemple code API, intégration pratique, ressources développement

Meta Description: Analyse complète des performances Qwen3-Max sur LMArena, guide détaillé des variantes (Base, Instruction, Thinking) et tutoriel d’intégration développement. Découvrez pourquoi ce LLM concurrence GPT-4 et Claude 3.

Balises SEO: #Qwen3Max #LLM #IntelligenceArtificielle #BenchmarkIA #DéveloppementIA #AlibabaCloud #GPT4 #Claude3 #LMArena #ModèleLangage